Açıklanabilir Yapay Zeka (Explainable AI-XAI)

Günümüz veri bilimi çağında yapay zeka, çarpıcı başarılara imza atıyor. Sürücüsüz arabalar, IBM Watson'ın soru-cevap sistemi, kanser tespiti vb. birçok zorlu uygulama yapay zekanın gelişmiş karar verme yeteneği sayesinde mümkün hale geliyor.

Sinir ağlarının derin katmanları, insan zihnini ve işlevlerini yeniden yaratma konusunda adeta sihirli bir yeteneğe sahiptir. İnsanlar karar verirken, arkasındaki düşünce sürecini açıklama yeteneğine sahiptirler. Bunun gözlemle mi, sezgiyle mi, deneyimle mi yoksa mantıksal düşünme yeteneğiyle mi yönlendirildiğini açıklayabilirler. Karar ağaçları gibi temel makine öğrenmesi algoritmaları, karara götüren ağaç yolunu takip ederek açıklanabilir. Ancak karmaşık yapay zeka algoritmaları söz konusu olduğunda, derin katmanlar genellikle insan sezgisiyle anlaşılamazlar. Veri bilimcileri, algoritmalarının verdiği bir kararın mantığını, kararı ne için ve nasıl verdiğini açıklamakta zorlanabilirler. Bu durum da son kullanıcının, bağlamsal kanıt ve akıl yürütme olmadan makinenin tahminlerine güvenmemesine neden olabilir. Yapay zeka sistemleri, günümüzde her ne kadar başarılı olsa da açıklanabilirlik konusunda yetersiz kalabilmekte ve sistemlerin sınırları bulunabilmektedir. Açıklanabilir AI (XAI, bazı kaynaklarda yorumlanabilir AI olarak da karşılaşabilirsiniz) burada devreye giriyor. Açıklanabilir AI sonuçların geliştirilmesine, anlaşılmasına ve yorumlanmasına yardımcı olan bir süreç paketidir. Ayrıca AI sistemlerinin oluşturulma şeklini de ele alır.

Yapay zekanın ortaya çıkmasının ve benimsenmesinin ilk aşamalarında, doğru çıktılar elde edildiği sürece, modelin belirli bir şekilde neyi öngördüğünü anlamamak pek fazla sorun teşkil etmemekteydi. Geçmişte nasıl çalıştıklarını açıklamak ilk öncelik değilken günümüzde odak noktası insan tarafından yorumlanabilir modellerin oluşturulmasıdır.

Sektörde iş paydaşlarının doğrusal modeller (doğrusal\lojistik regresyon) gibi daha yorumlanabilir modelleri ve sezgisel, doğrulanması ve veri biliminde uzman olmayan bir kişiye açıklaması kolay olan ağaç yöntemlerini tercih etme eğiliminde olduğunu sık sık gözlemleyebilirsiniz. Buna karşılık, gerçek hayat verilerinin karmaşık yapısına baktığımızda model oluşturma ve seçim aşamasında ilgi daha çok gelişmiş modellere kaymaktadır. Bu şekilde daha iyi tahminlerin elde edilme olasılığı daha yüksektir. Bunun gibi gelişmiş modeller (sinir ağları vb.) kara kutu modelleri olarak adlandırılır. Model karmaşıklaştıkça, nasıl çalıştığını açıklamak zorlaşır. Girdiler sihirli bir şekilde bir kutuya giriyor ve içeride hangi işlemlerin gerçekleştirildiği bilinmeden harika sonuçlar elde ediliyor. Peki ama nasıl?

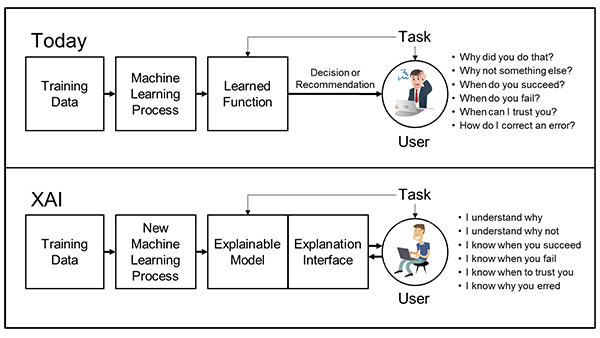

Ortadaki süreçte neler olduğunu tam olarak bilmemekteyiz. Bu nedenle bir kara kutu tasviri yapılmaktadır. Kara kutu içerisinde neler olduğunu bilmediğimizden modelin ürettiği çıktıyla ilgili aklımızda farklı sorular oluşabilmektedir. “Neden bunu yaptı? Neden başka bir şey yapmadı? Ne zaman başarılı ve ne zaman başarısız olur? Ne zaman ona güvenmeliyim? Hatayı nasıl düzeltebilirim?” gibi modelin iç yapısına yönelik sorulara açıklanabilir yapay zeka ile yanıt bulabiliriz.

Paydaşlarımıza bir model önerdiğimizde modele neden güvenmeleri gerektiği, modelin neden belirli bir kararı aldığı ve model tahminlerini nelerin yönlendirdiği gibi bize model ile ilgili çeşitli sorular yöneltilebilir. Bu nedenle model doğruluğunu geliştirmeyi hedeflerken aynı zamanda modelin açıklanabilirliği üzerinde de yoğunlaşmamız gerekir.

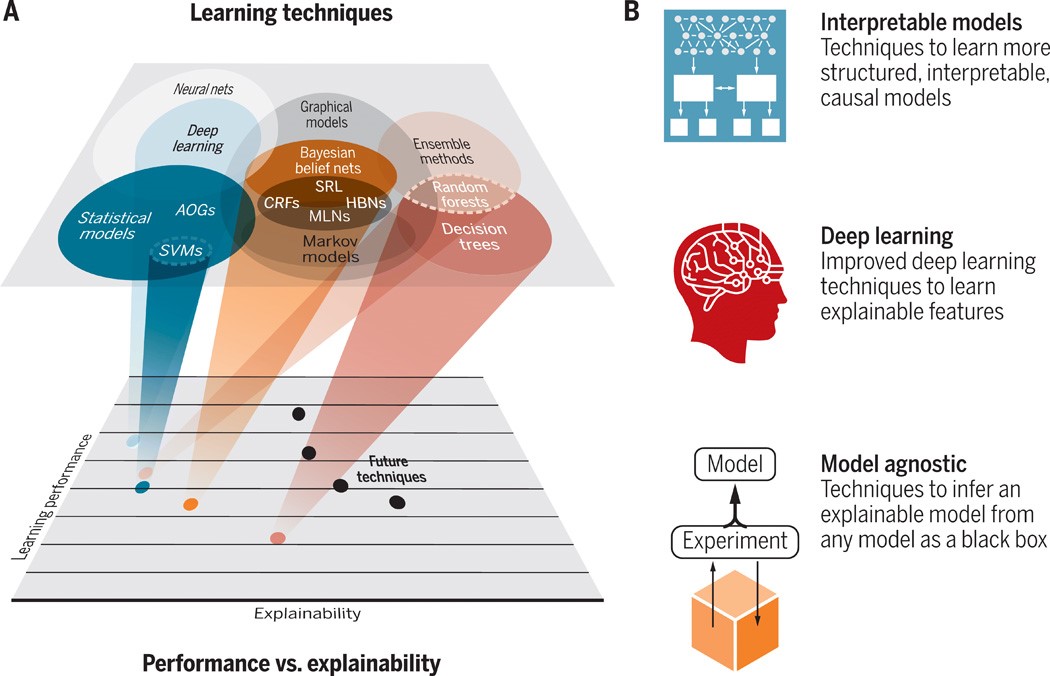

Bazı modeller yüksek performans sergilemelerine rağmen açıklanabilirlik açısından opaktırlar. Makine öğrenimi performansı (örneğin tahmine dayalı doğruluk) ile açıklanabilirlik arasında doğal bir çelişki olabilir. Çoğu zaman yüksek performanslı yöntemler (örneğin derin öğrenme) en az açıklanabilir yöntemlerken en açıklanabilir yöntemler (örneğin karar ağaçları) daha düşük performansa sahiptirler. Aşağıdaki görsel, bunu bazı ML teknikleri için performans-açıklanabilirlik değiş tokuşunun kavramsal bir grafiğiyle göstermektedir.

Kullandığımız sistemleri anlama talebi oldukça doğaldır. Yapay zeka tabanlı yazılım sistemlerini anlamanın getirdiği zorluklar nedeniyle, bu sistemlerin açıklanabilirliğine artan bir ilgi vardır. Sistemi anlama, kararları gerekçelendirme, güven sağlama ve kullanılabilirliği artırma gibi birçok faktör açısından açıklanabilirlik oldukça önemlidir. Ayrıca yetersiz açıklamalar, güvensizliği artırmakta, kullanıcıların sistemi kabul ve memnuniyetlerini azaltmakta ve yeni teknolojilerin adapte edilmesini zorlaştırmaktadır. Sonuç olarak açıklanabilirlik, AI tabanlı yazılım sistemlerindeki eserlerin kalitesini iyileştirmek için kritik bir özelliktir ve bu sistemlerin geliştirilmesi boyunca dikkate alınması gerekir.

Açıklanabilirlik kavramına dayalı olarak insanların yapay zeka modellerini anlamasına, güvenmesine ve yönetmesine olanak tanıyan çeşitli makine öğrenimi teknikleri ortaya çıkmıştır. İnsan tarafından anlaşılabilir sonuçlar üretmek ve makine öğrenmesi modellerinin ne kadar açıklanabilir olduğunu ölçmek için teknikler geliştirilir.

Geliştirilen Teknikler

- ELI5: Makine öğrenmesi model tahminlerini açıklamaya yardımcı olan bir Python kütüphanesidir. 5 yaşındaymışım gibi açıkla (‘explain like I’m 5 [years old]’) cümlesinin kısaltılmışıdır. Ağaç tabanlı ve doğrusal modelleri anlamamızı sağlar.

- SHAP: 2016 yılında Lundberg ve Lee tarafından hazırlanan, açılımı “SHapley Additive exPlanations” olan bu yöntem, herhangi bir makine öğrenimi modelinin çıktısını açıklamak için geliştirilen bir oyun teorisi yaklaşımdır. Oyun teorisinden optimal Shapley değerlerine dayalı olarak bireysel tahminleri açıklar. SHAP'ın amacı, her bir özelliğin y tahminine katkısını hesaplayarak bir x örneğinin tahminini açıklamaktır.

- LIME (Local Interpretable Model-Agnostic Explanations): Modelden bağımsız olan bu yöntem, herhangi bir makine öğrenimi modelini aydınlatmaya ve tahminlerini ayrı ayrı anlaşılır hale getirmeye yardımcı olur. Yöntem, belirli bir tek örnek için tahminin nasıl değiştiğini anlayarak algoritmayı açıklar ve bu nedenle yerel açıklamalar için uygundur.

Literatürde yapay zeka açıklanabilirliği için geliştirilmiş yöntemlerden yalnızca üçü olan yukarıdaki yöntemler kara kutu modellerinin iç işleyişine ışık tutarak tahminlerin arkasındaki mantığın açıklanmasını sağlamaktadır.

Açıklanabilir yapay zekanın faydaları nelerdir ve bir modelin açıklanabilir olması neden önemlidir?

Özellikle sağlık hizmetleri gibi gizli ve hassas bilgilerin bulunduğu sektörlerde, analitik ve şeffaf kararlar gerektiren durumlarda açıklanabilir yapay zekanın önemi göz ardı edilemez. Bunu bir örnek üzerinden açıklayalım. Bir hasta verisi üzerinde çalıştığınızı ve yapay sinir ağı ile kalp hastalığını tahmin etmeye çalıştığınızı varsayalım. Modelinizi eğitip test ettiğinizde iyi bir sonuç elde edersiniz ve bunu bir doktora gösterdiğinizde doktorunuz kullandığınız modelin güçlü bir model olduğu konusunda hemfikir olmakla birlikte modeli kullanma konusunda tereddüt edecektir. Çünkü model “Neden bu kişinin kalp hastalığına yakalanma olasılığının daha yüksek olduğunu tahmin ettiniz?” sorusunu yanıtlamakta yetersiz kalacaktır. Modelin nasıl çalıştığının açıklanamaması somut bir neden arayan hasta için de sorun teşkil edecektir. Modelin karar sürecinin açıklanabilir olması model karar verme sürecinde daha yüksek düzeyde görünürlük sunarken insanlar ve makineler arasında güvenilir etkileşimlerin kurulmasına olanak sağlar.

Yukarıda açıklanabilir yapay zekanın faydalarından ve öneminden bahsettik. Zorluklarından da bahsedecek olursak ilk olarak XAI, araştırma alanlarında nispeten yeni bir teknolojik kavramdır. Bu nedenle, hala ele alınması gereken zorlukları mevcuttur. Ortaya çıkan ilk zorluk, model performans doğruluğunun maliyetidir. XAI sistemleri hala gelişmekte olduğundan daha düşük performansa sahiptirler. XAI modellerinin eğitilmesi de karmaşık sinir ağları ve algoritmalar nedeniyle daha zordur. Ayrıca bu bileşenleri ve işlevlerini anlamak, doğaları gereği karmaşıktır. Aynı zamanda karmaşık ve eğitilmesi zor olduğundan, XAI sistemleri dağıtım sırasında da sorunlarla karşılaşabilir.

Bu yazımda, yeni bir kavram olan açıklanabilir yapay zeka (XAI) nedir ve neden önemlidir konularına değindim. Henüz yeni bir kavram olduğundan literatürde konuyla alakalı çeşitli görüşler yer almaktadır. Kısaca özetleyecek olursak, yapay zeka ile ilgili hem model performansımızı arttırmayı hem de açıklamalarda kaybolmamayı düşünmeli ve ikisi arasındaki dengeyi sağlamalıyız. Gelişen yapay zeka sistemleri ile ileride hem model başarısının hem de açıklanabilirliğin yüksek olması beklenmektedir. Bu konu üzerinde DARPA, Google, DeepMind vb. kurumlar yoğun bir şekilde çalışmalarını sürdürmektedir. Bu kurumların sunduğu raporlara göre bir süre model performansı ve açıklanabilirliği arasında bir tradeoff yapmak kaçınılmazdır.

Kaynaklar

- KDnuggets, Explainable Artificial Intelligence

- Hitechnectar, Know more about the concept of Explainable AI and its Examples

- Analyticsvidhya, Explain How Your Model Works Using Explainable AI

- Science Robotics, XAI-Explainable artificial intelligence

- FreeCodeCamp, An introduction to explainable AI, and why we need it

- TowardsDataScience, Explainable AI (XAI) with SHAP - regression problem

- DARPA, Explainable Artificial Intelligence

- E. H. Pflugfelder (2017), Reddit’s “Explain Like I’m Five”: Technical Descriptions in the Wild

- S. M. Lundberg and S. Lee (2017), A Unified Approach to Interpreting Model Predictions

- M. T. Ribeiro and C. Guestrin (2016), Why Should I Trust You ?’ Explaining the Predictions of Any Classifier